PVE8.1 NVIDIA显卡虚拟化多开VGPU16.2--基于1050Ti

顺带接有偿部署,有需要点击链接闲鱼与我联系

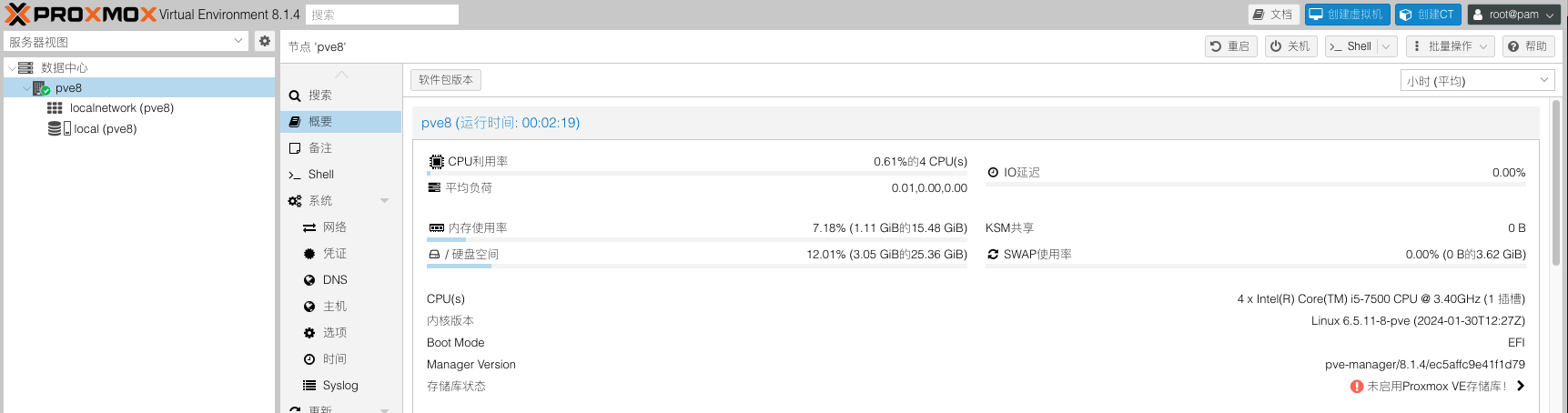

记录6.5内核的PVE8.1版本配置NVIDIA显卡虚拟化的一些设置,基于GTX1050Ti。

硬件配置

| 配置 | 型号 |

|---|---|

| 系统 | PVE 8.1.4 |

| 内核 | Linux 6.5.11-8-pve |

| CPU | Intel Core i5-7500 @ 3.4GHz 4核4线程 |

| 显卡 | GTX1050 Ti 4096MB |

| VGPU驱动 | 535.129.03 |

点我展开

消费级显卡支持10系列20系列但不支持30系列40系列| 设备ID | 显卡型号 | VGPU模拟型号 |

|---|---|---|

| 21c4 | TU116 GeForce GTX 1660 SUPER | Quadro RTX 6000 |

| 21d1 | TU116BM GeForce GTX 1660 Ti Mobile | Quadro RTX 6000 |

| 21c2 | TU116 | Quadro RTX 6000 |

| 2182 | TU116 GeForce GTX 1660 Ti | Quadro RTX 6000 |

| 2183 | TU116 | Quadro RTX 6000 |

| 2184 | TU116 GeForce GTX 1660 | Quadro RTX 6000 |

| 2187 | TU116 GeForce GTX 1650 SUPER | Quadro RTX 6000 |

| 2188 | TU116 GeForce GTX 1650 | Quadro RTX 6000 |

| 2191 | TU116M GeForce GTX 1660 Ti Mobile | Quadro RTX 6000 |

| 2192 | TU116M GeForce GTX 1650 Ti Mobile | Quadro RTX 6000 |

| 21ae | TU116GL | Quadro RTX 6000 |

| 21bf | TU116GL | Quadro RTX 6000 |

| 2189 | TU116 CMP 30HX | Quadro RTX 6000 |

| 1fbf | TU117GL | Quadro RTX 6000 |

| 1fbb | TU117GLM Quadro T500 Mobile | Quadro RTX 6000 |

| 1fd9 | TU117BM GeForce GTX 1650 Mobile Refresh | Quadro RTX 6000 |

| 1ff9 | TU117GLM Quadro T1000 Mobile | Quadro RTX 6000 |

| 1fdd | TU117BM GeForce GTX 1650 Mobile Refresh | Quadro RTX 6000 |

| 1f96 | TU117M GeForce GTX 1650 Mobile / Max-Q | Quadro RTX 6000 |

| 1f99 | TU117M | Quadro RTX 6000 |

| 1fae | TU117GL | Quadro RTX 6000 |

| 1fb8 | TU117GLM Quadro T2000 Mobile / Max-Q | Quadro RTX 6000 |

| 1fb9 | TU117GLM Quadro T1000 Mobile | Quadro RTX 6000 |

| 1f97 | TU117M GeForce MX450 | Quadro RTX 6000 |

| 1f98 | TU117M GeForce MX450 | Quadro RTX 6000 |

| 1f9c | TU117M GeForce MX450 | Quadro RTX 6000 |

| 1f9d | TU117M GeForce GTX 1650 Mobile / Max-Q | Quadro RTX 6000 |

| 1fb0 | TU117GLM Quadro T1000 Mobile | Quadro RTX 6000 |

| 1fb1 | TU117GL T600 | Quadro RTX 6000 |

| 1fb2 | TU117GLM Quadro T400 Mobile | Quadro RTX 6000 |

| 1fba | TU117GLM T600 Mobile | Quadro RTX 6000 |

| 1f42 | TU106 GeForce RTX 2060 SUPER | Quadro RTX 6000 |

| 1f47 | TU106 GeForce RTX 2060 SUPER | Quadro RTX 6000 |

| 1f50 | TU106BM GeForce RTX 2070 Mobile / Max-Q | Quadro RTX 6000 |

| 1f51 | TU106BM GeForce RTX 2060 Mobile | Quadro RTX 6000 |

| 1f54 | TU106BM GeForce RTX 2070 Mobile | Quadro RTX 6000 |

| 1f55 | TU106BM GeForce RTX 2060 Mobile | Quadro RTX 6000 |

| 1f81 | TU117 | Quadro RTX 6000 |

| 1f82 | TU117 GeForce GTX 1650 | Quadro RTX 6000 |

| 1f91 | TU117M GeForce GTX 1650 Mobile / Max-Q | Quadro RTX 6000 |

| 1f92 | TU117M GeForce GTX 1650 Mobile | Quadro RTX 6000 |

| 1f94 | TU117M GeForce GTX 1650 Mobile | Quadro RTX 6000 |

| 1f95 | TU117M GeForce GTX 1650 Ti Mobile | Quadro RTX 6000 |

| 1f76 | TU106GLM Quadro RTX 3000 Mobile Refresh | Quadro RTX 6000 |

| 1f07 | TU106 GeForce RTX 2070 Rev. A | Quadro RTX 6000 |

| 1f08 | TU106 GeForce RTX 2060 Rev. A | Quadro RTX 6000 |

| 1f09 | TU106 GeForce GTX 1660 SUPER | Quadro RTX 6000 |

| 1f0a | TU106 GeForce GTX 1650 | Quadro RTX 6000 |

| 1f10 | TU106M GeForce RTX 2070 Mobile | Quadro RTX 6000 |

| 1f11 | TU106M GeForce RTX 2060 Mobile | Quadro RTX 6000 |

| 1f12 | TU106M GeForce RTX 2060 Max-Q | Quadro RTX 6000 |

| 1f14 | TU106M GeForce RTX 2070 Mobile / Max-Q Refresh | Quadro RTX 6000 |

| 1f15 | TU106M GeForce RTX 2060 Mobile | Quadro RTX 6000 |

| 1f2e | TU106M | Quadro RTX 6000 |

| 1f36 | TU106GLM Quadro RTX 3000 Mobile / Max-Q | Quadro RTX 6000 |

| 1f0b | TU106 CMP 40HX | Quadro RTX 6000 |

| 1eb5 | TU104GLM Quadro RTX 5000 Mobile / Max-Q | Quadro RTX 6000 |

| 1eb6 | TU104GLM Quadro RTX 4000 Mobile / Max-Q | Quadro RTX 6000 |

| 1eb8 | TU104GL Tesla T4 | Quadro RTX 6000 |

| 1eb9 | TU104GL | Quadro RTX 6000 |

| 1ebe | TU104GL | Quadro RTX 6000 |

| 1ec2 | TU104 GeForce RTX 2070 SUPER | Quadro RTX 6000 |

| 1ec7 | TU104 GeForce RTX 2070 SUPER | Quadro RTX 6000 |

| 1ed0 | TU104BM GeForce RTX 2080 Mobile | Quadro RTX 6000 |

| 1ed1 | TU104BM GeForce RTX 2070 SUPER Mobile / Max-Q | Quadro RTX 6000 |

| 1ed3 | TU104BM GeForce RTX 2080 SUPER Mobile / Max-Q | Quadro RTX 6000 |

| 1f02 | TU106 GeForce RTX 2070 | Quadro RTX 6000 |

| 1f04 | TU106 | Quadro RTX 6000 |

| 1f06 | TU106 GeForce RTX 2060 SUPER | Quadro RTX 6000 |

| 1ef5 | TU104GLM Quadro RTX 5000 Mobile Refresh | Quadro RTX 6000 |

| 1e81 | TU104 GeForce RTX 2080 SUPER | Quadro RTX 6000 |

| 1e82 | TU104 GeForce RTX 2080 | Quadro RTX 6000 |

| 1e84 | TU104 GeForce RTX 2070 SUPER | Quadro RTX 6000 |

| 1e87 | TU104 GeForce RTX 2080 Rev. A | Quadro RTX 6000 |

| 1e89 | TU104 GeForce RTX 2060 | Quadro RTX 6000 |

| 1e90 | TU104M GeForce RTX 2080 Mobile | Quadro RTX 6000 |

| 1e91 | TU104M GeForce RTX 2070 SUPER Mobile / Max-Q | Quadro RTX 6000 |

| 1e93 | TU104M GeForce RTX 2080 SUPER Mobile / Max-Q | Quadro RTX 6000 |

| 1eab | TU104M | Quadro RTX 6000 |

| 1eae | TU104M | Quadro RTX 6000 |

| 1eb0 | TU104GL Quadro RTX 5000 | Quadro RTX 6000 |

| 1eb1 | TU104GL Quadro RTX 4000 | Quadro RTX 6000 |

| 1eb4 | TU104GL T4G | Quadro RTX 6000 |

| 1e04 | TU102 GeForce RTX 2080 Ti | Quadro RTX 6000 |

| 1e07 | TU102 GeForce RTX 2080 Ti Rev. A | Quadro RTX 6000 |

| 1e2d | TU102 GeForce RTX 2080 Ti Engineering Sample | Quadro RTX 6000 |

| 1e2e | TU102 GeForce RTX 2080 Ti 12GB Engineering Sample | Quadro RTX 6000 |

| 1e30 | TU102GL Quadro RTX 6000/8000 | Quadro RTX 6000 |

| 1e36 | TU102GL Quadro RTX 6000 | Quadro RTX 6000 |

| 1e37 | TU102GL GRID RTX T10-4/T10-8/T10-16 | Quadro RTX 6000 |

| 1e38 | TU102GL | Quadro RTX 6000 |

| 1e3c | TU102GL | Quadro RTX 6000 |

| 1e3d | TU102GL | Quadro RTX 6000 |

| 1e3e | TU102GL | Quadro RTX 6000 |

| 1e78 | TU102GL Quadro RTX 6000/8000 | Quadro RTX 6000 |

| 1e09 | TU102 CMP 50HX | Quadro RTX 6000 |

| 1dba | GV100GL Quadro GV100 | Tesla V100 32GB PCIE |

| 1e02 | TU102 TITAN RTX | Quadro RTX 6000 |

| 1cfa | GP107GL Quadro P2000 | Tesla P40 |

| 1cfb | GP107GL Quadro P1000 | Tesla P40 |

| 1d01 | GP108 GeForce GT 1030 | Tesla P40 |

| 1d10 | GP108M GeForce MX150 | Tesla P40 |

| 1d11 | GP108M GeForce MX230 | Tesla P40 |

| 1d12 | GP108M GeForce MX150 | Tesla P40 |

| 1d13 | GP108M GeForce MX250 | Tesla P40 |

| 1d16 | GP108M GeForce MX330 | Tesla P40 |

| 1d33 | GP108GLM Quadro P500 Mobile | Tesla P40 |

| 1d34 | GP108GLM Quadro P520 | Tesla P40 |

| 1d52 | GP108BM GeForce MX250 | Tesla P40 |

| 1d56 | GP108BM GeForce MX330 | Tesla P40 |

| 1d81 | GV100 TITAN V | Tesla V100 32GB PCIE |

| 1cb6 | GP107GL Quadro P620 | Tesla P40 |

| 1cba | GP107GLM Quadro P2000 Mobile | Tesla P40 |

| 1cbb | GP107GLM Quadro P1000 Mobile | Tesla P40 |

| 1cbc | GP107GLM Quadro P600 Mobile | Tesla P40 |

| 1cbd | GP107GLM Quadro P620 | Tesla P40 |

| 1ccc | GP107BM GeForce GTX 1050 Ti Mobile | Tesla P40 |

| 1ccd | GP107BM GeForce GTX 1050 Mobile | Tesla P40 |

| 1ca8 | GP107GL | Tesla P40 |

| 1caa | GP107GL | Tesla P40 |

| 1cb1 | GP107GL Quadro P1000 | Tesla P40 |

| 1cb2 | GP107GL Quadro P600 | Tesla P40 |

| 1cb3 | GP107GL Quadro P400 | Tesla P40 |

| 1c70 | GP106GL | Tesla P40 |

| 1c81 | GP107 GeForce GTX 1050 | Tesla P40 |

| 1c82 | GP107 GeForce GTX 1050 Ti | Tesla P40 |

| 1c83 | GP107 GeForce GTX 1050 3GB | Tesla P40 |

| 1c8c | GP107M GeForce GTX 1050 Ti Mobile | Tesla P40 |

| 1c8d | GP107M GeForce GTX 1050 Mobile | Tesla P40 |

| 1c8e | GP107M | Tesla P40 |

| 1c8f | GP107M GeForce GTX 1050 Ti Max-Q | Tesla P40 |

| 1c90 | GP107M GeForce MX150 | Tesla P40 |

| 1c91 | GP107M GeForce GTX 1050 3 GB Max-Q | Tesla P40 |

| 1c92 | GP107M GeForce GTX 1050 Mobile | Tesla P40 |

| 1c94 | GP107M GeForce MX350 | Tesla P40 |

| 1c96 | GP107M GeForce MX350 | Tesla P40 |

| 1ca7 | GP107GL | Tesla P40 |

| 1c36 | GP106 P106M | Tesla P40 |

| 1c07 | GP106 P106-100 | Tesla P40 |

| 1c09 | GP106 P106-090 | Tesla P40 |

| 1c20 | GP106M GeForce GTX 1060 Mobile | Tesla P40 |

| 1c21 | GP106M GeForce GTX 1050 Ti Mobile | Tesla P40 |

| 1c22 | GP106M GeForce GTX 1050 Mobile | Tesla P40 |

| 1c23 | GP106M GeForce GTX 1060 Mobile Rev. 2 | Tesla P40 |

| 1c2d | GP106M | Tesla P40 |

| 1c30 | GP106GL Quadro P2000 | Tesla P40 |

| 1c31 | GP106GL Quadro P2200 | Tesla P40 |

| 1c35 | GP106M Quadro P2000 Mobile | Tesla P40 |

| 1c60 | GP106BM GeForce GTX 1060 Mobile 6GB | Tesla P40 |

| 1c61 | GP106BM GeForce GTX 1050 Ti Mobile | Tesla P40 |

| 1c62 | GP106BM GeForce GTX 1050 Mobile | Tesla P40 |

| 1bb8 | GP104GLM Quadro P3000 Mobile | Tesla P40 |

| 1bb9 | GP104GLM Quadro P4200 Mobile | Tesla P40 |

| 1bbb | GP104GLM Quadro P3200 Mobile | Tesla P40 |

| 1bc7 | GP104 P104-101 | Tesla P40 |

| 1be0 | GP104BM GeForce GTX 1080 Mobile | Tesla P40 |

| 1be1 | GP104BM GeForce GTX 1070 Mobile | Tesla P40 |

| 1c00 | GP106 | Tesla P40 |

| 1c01 | GP106 | Tesla P40 |

| 1c02 | GP106 GeForce GTX 1060 3GB | Tesla P40 |

| 1c03 | GP106 GeForce GTX 1060 6GB | Tesla P40 |

| 1c04 | GP106 GeForce GTX 1060 5GB | Tesla P40 |

| 1c06 | GP106 GeForce GTX 1060 6GB Rev. 2 | Tesla P40 |

| 1b87 | GP104 P104-100 | Tesla P40 |

| 1ba0 | GP104M GeForce GTX 1080 Mobile | Tesla P40 |

| 1ba1 | GP104M GeForce GTX 1070 Mobile | Tesla P40 |

| 1ba2 | GP104M GeForce GTX 1070 Mobile | Tesla P40 |

| 1ba9 | GP104M | Tesla P40 |

| 1baa | GP104M | Tesla P40 |

| 1bad | GP104 GeForce GTX 1070 Engineering Sample | Tesla P40 |

| 1bb0 | GP104GL Quadro P5000 | Tesla P40 |

| 1bb1 | GP104GL Quadro P4000 | Tesla P40 |

| 1bb3 | GP104GL Tesla P4 | Tesla P40 |

| 1bb4 | GP104GL Tesla P6 | Tesla P40 |

| 1bb5 | GP104GLM Quadro P5200 Mobile | Tesla P40 |

| 1bb6 | GP104GLM Quadro P5000 Mobile | Tesla P40 |

| 1bb7 | GP104GLM Quadro P4000 Mobile | Tesla P40 |

| 1b06 | GP102 GeForce GTX 1080 Ti | Tesla P40 |

| 1b07 | GP102 P102-100 | Tesla P40 |

| 1b30 | GP102GL Quadro P6000 | Tesla P40 |

| 1b38 | GP102GL Tesla P40 | Tesla P40 |

| 1b70 | GP102GL | Tesla P40 |

| 1b78 | GP102GL | Tesla P40 |

| 1b80 | GP104 GeForce GTX 1080 | Tesla P40 |

| 1b81 | GP104 GeForce GTX 1070 | Tesla P40 |

| 1b82 | GP104 GeForce GTX 1070 Ti | Tesla P40 |

| 1b83 | GP104 GeForce GTX 1060 6GB | Tesla P40 |

| 1b84 | GP104 GeForce GTX 1060 3GB | Tesla P40 |

| 1b39 | GP102GL Tesla P10 | Tesla P40 |

| 1b00 | GP102 TITAN X | Tesla P40 |

| 1b01 | GP102 GeForce GTX 1080 Ti 10GB | Tesla P40 |

| 1b02 | GP102 TITAN Xp | Tesla P40 |

| 1b04 | GP102 | Tesla P40 |

| 179c | GM107 GeForce 940MX | Tesla M10 |

| 17c2 | GM200 GeForce GTX TITAN X | Tesla M60 |

| 17c8 | GM200 GeForce GTX 980 Ti | Tesla M60 |

| 17f0 | GM200GL Quadro M6000 | Tesla M60 |

| 17f1 | GM200GL Quadro M6000 24GB | Tesla M60 |

| 17fd | GM200GL Tesla M40 | Tesla M60 |

| 1617 | GM204M GeForce GTX 980M | Tesla M60 |

| 1618 | GM204M GeForce GTX 970M | Tesla M60 |

| 1619 | GM204M GeForce GTX 965M | Tesla M60 |

| 161a | GM204M GeForce GTX 980 Mobile | Tesla M60 |

| 1667 | GM204M GeForce GTX 965M | Tesla M60 |

| 1725 | GP100 | Tesla P40 |

| 172e | GP100 | Tesla P40 |

| 172f | GP100 | Tesla P40 |

| 174d | GM108M GeForce MX130 | Tesla M10 |

| 174e | GM108M GeForce MX110 | Tesla M10 |

| 1789 | GM107GL GRID M3-3020 | Tesla M10 |

| 1402 | GM206 GeForce GTX 950 | Tesla M60 |

| 1406 | GM206 GeForce GTX 960 OEM | Tesla M60 |

| 1407 | GM206 GeForce GTX 750 v2 | Tesla M60 |

| 1427 | GM206M GeForce GTX 965M | Tesla M60 |

| 1430 | GM206GL Quadro M2000 | Tesla M60 |

| 1431 | GM206GL Tesla M4 | Tesla M60 |

| 1436 | GM206GLM Quadro M2200 Mobile | Tesla M60 |

| 15f0 | GP100GL Quadro GP100 | Tesla P40 |

| 15f1 | GP100GL | Tesla P40 |

| 1404 | GM206 GeForce GTX 960 FAKE | Tesla M60 |

| 13d8 | GM204M GeForce GTX 970M | Tesla M60 |

| 13d9 | GM204M GeForce GTX 965M | Tesla M60 |

| 13da | GM204M GeForce GTX 980 Mobile | Tesla M60 |

| 13e7 | GM204GL GeForce GTX 980 Engineering Sample | Tesla M60 |

| 13f0 | GM204GL Quadro M5000 | Tesla M60 |

| 13f1 | GM204GL Quadro M4000 | Tesla M60 |

| 13f2 | GM204GL Tesla M60 | Tesla M60 |

| 13f3 | GM204GL Tesla M6 | Tesla M60 |

| 13f8 | GM204GLM Quadro M5000M / M5000 SE | Tesla M60 |

| 13f9 | GM204GLM Quadro M4000M | Tesla M60 |

| 13fa | GM204GLM Quadro M3000M | Tesla M60 |

| 13fb | GM204GLM Quadro M5500 | Tesla M60 |

| 1401 | GM206 GeForce GTX 960 | Tesla M60 |

| 13b3 | GM107GLM Quadro K2200M | Tesla M10 |

| 13b4 | GM107GLM Quadro M620 Mobile | Tesla M10 |

| 13b6 | GM107GLM Quadro M1200 Mobile | Tesla M10 |

| 13b9 | GM107GL NVS 810 | Tesla M10 |

| 13ba | GM107GL Quadro K2200 | Tesla M10 |

| 13bb | GM107GL Quadro K620 | Tesla M10 |

| 13bc | GM107GL Quadro K1200 | Tesla M10 |

| 13bd | GM107GL Tesla M10 | Tesla M10 |

| 13c0 | GM204 GeForce GTX 980 | Tesla M60 |

| 13c1 | GM204 | Tesla M60 |

| 13c2 | GM204 GeForce GTX 970 | Tesla M60 |

| 13c3 | GM204 | Tesla M60 |

| 13d7 | GM204M GeForce GTX 980M | Tesla M60 |

| 1389 | GM107GL GRID M30 | Tesla M10 |

| 1390 | GM107M GeForce 845M | Tesla M10 |

| 1391 | GM107M GeForce GTX 850M | Tesla M10 |

| 1392 | GM107M GeForce GTX 860M | Tesla M10 |

| 1393 | GM107M GeForce 840M | Tesla M10 |

| 1398 | GM107M GeForce 845M | Tesla M10 |

| 1399 | GM107M GeForce 945M | Tesla M10 |

| 139a | GM107M GeForce GTX 950M | Tesla M10 |

| 139b | GM107M GeForce GTX 960M | Tesla M10 |

| 139c | GM107M GeForce 940M | Tesla M10 |

| 139d | GM107M GeForce GTX 750 Ti | Tesla M10 |

| 13b0 | GM107GLM Quadro M2000M | Tesla M10 |

| 13b1 | GM107GLM Quadro M1000M | Tesla M10 |

| 13b2 | GM107GLM Quadro M600M | Tesla M10 |

| 1347 | GM108M GeForce 940M | Tesla M10 |

| 1348 | GM108M GeForce 945M / 945A | Tesla M10 |

| 1349 | GM108M GeForce 930M | Tesla M10 |

| 134b | GM108M GeForce 940MX | Tesla M10 |

| 134d | GM108M GeForce 940MX | Tesla M10 |

| 134e | GM108M GeForce 930MX | Tesla M10 |

| 134f | GM108M GeForce 920MX | Tesla M10 |

| 137a | GM108GLM Quadro K620M / Quadro M500M | Tesla M10 |

| 137b | GM108GLM Quadro M520 Mobile | Tesla M10 |

| 137d | GM108M GeForce 940A | Tesla M10 |

| 1380 | GM107 GeForce GTX 750 Ti | Tesla M10 |

| 1381 | GM107 GeForce GTX 750 | Tesla M10 |

| 1382 | GM107 GeForce GTX 745 | Tesla M10 |

| 1340 | GM108M GeForce 830M | Tesla M10 |

| 1341 | GM108M GeForce 840M | Tesla M10 |

| 1344 | GM108M GeForce 845M | Tesla M10 |

| 1346 | GM108M GeForce 930M | Tesla M10 |

PVE基本设置

安装PVE过程略过,提前将pve安装好,在安装VGPU前先将pve底层设置优化一下

本篇文章将大量使用nano文本编辑命令,至于怎么使用自行百度,这里不重复造轮子了。 知道如何保存就行Ctrl +X 输入“Y”回车保存

BIOS设置

提前在BIOS开启以下参数

- 开启VT-d --硬件直通必须开启

- 开启SRIOV --如有

- 开启Above 4G --如有

关闭安全启动 --

在security菜单 secure boot 改disabled

更换系统源

国内清华源

编辑sources.list,将原有的源链接在句首加 # 注释掉,更换以下清华源信息nano /etc/apt/sources.list

deb https://mirrors.tuna.tsinghua.edu.cn/debian/ bookworm main contrib non-free non-free-firmware

deb https://mirrors.tuna.tsinghua.edu.cn/debian/ bookworm-updates main contrib non-free non-free-firmware

deb https://mirrors.tuna.tsinghua.edu.cn/debian/ bookworm-backports main contrib non-free non-free-firmware

deb https://mirrors.tuna.tsinghua.edu.cn/debian-security bookworm-security main contrib non-free non-free-firmware更换企业源

国内清华源

编辑pve-enterprise.list,将原有的源链接在句首加 # 注释掉,更换以下清华源信息nano /etc/apt/sources.list.d/pve-enterprise.list

deb https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian bookworm pve-no-subscription修复源401错误

编辑ceph.list,将原有的源链接在句首加 # 注释掉,添加中科大ceph源nano /etc/apt/sources.list.d/ceph.list

deb https://mirrors.ustc.edu.cn/proxmox/debian/ceph-quincy bookworm no-subscription执行更新源

apt update LXC容器更源

国内清华源

# 备份APLInfo.pm

cp /usr/share/perl5/PVE/APLInfo.pm /usr/share/perl5/PVE/APLInfo.pm_back

# 替换为清华源:

sed -i 's|http://download.proxmox.com|https://mirrors.tuna.tsinghua.edu.cn/proxmox|g' /usr/share/perl5/PVE/APLInfo.pm

# 重启服务后生效

systemctl restart pvedaemon.servicePVE常用优化脚本

可以做下以下优化1)去掉登录订阅提示;2)合并local-lvm以最大化利用硬盘空间;3)添加CPU频率硬盘温度;4)删掉不用的内核等信息,减少驱动安装不上等问题;

# 下载pve_source二进制文件到/root目录

wget https://yangwenqing.com/files/pve/pve_source.tar.gz && tar zxvf /root/pve_source.tar.gz && /root/./pve_source开启硬件直通

需要提前在主板BIOS开启虚拟化功能,才能开启硬件直通。在BIOS开启vt-d,AMD平台是iommu,并且开启SRIOV和Above 4G选项

Intel CPU

使用nano命令编辑grubnano /etc/default/grub

# 开启iommu分组,在里面找到:GRUB_CMDLINE_LINUX_DEFAULT="quiet"项将其修改为

GRUB_CMDLINE_LINUX_DEFAULT="quiet intel_iommu=on iommu=pt pcie_acs_override=downstream,multifunction"

# 更新grub

update-grub加载内核模块

加载内核模块,使用nano命令加入以下信息nano /etc/modules

vfio

vfio_iommu_type1

vfio_pci

vfio_virqfd屏蔽设备

添加设备黑名单,编辑pve-blacklist.confnano /etc/modprobe.d/pve-blacklist.conf

# 直通AMD显卡,请使用下面命令

blacklist radeon

blacklist amdgpu

# 直通NVIDIA显卡,请使用下面命令

blacklist nouveau

blacklist nvidia

blacklist nvidiafb

# 直通INTEL核显,请使用下面命令

blacklist i915

blacklist snd_hda_intel

blacklist snd_hda_codec_hdmi

# 允许不安全的设备中断

options vfio_iommu_type1 allow_unsafe_interrupts=1执行更新initramfs

# 更新initramfs

update-initramfs -u -k all

# 重启

reboot验证是否开启直通

# 验证是否开启iommu

dmesg | grep iommu

或者

dmesg | grep -e DMAR -e IOMMU -e AMD-Vi出现如下例子。则代表成功

[ 1.341100] pci 0000:00:00.0: Adding to iommu group 0

[ 1.341116] pci 0000:00:01.0: Adding to iommu group 1

[ 1.341126] pci 0000:00:02.0: Adding to iommu group 2

[ 1.341137] pci 0000:00:14.0: Adding to iommu group 3

[ 1.341146] pci 0000:00:17.0: Adding to iommu group 4此时输入命令

find /sys/kernel/iommu_groups/ -type l

#出现很多直通组,就代表成功了。如果没有任何东西,就是没有开启lsmod | grep vfio

# 检测模块是否加载vfio_pci 16384 4

vfio_pci_core 94208 1 vfio_pci

vfio_iommu_type1 49152 2

vfio 57344 17 vfio_pci_core,vfio_iommu_type1,vfio_pci

iommufd 73728 1 vfio

irqbypass 16384 41 vfio_pci_core,kvm

#出现这类信息,就代表成功了。配置VGPU_Unlock

# 创建vgpu_unlock文件夹

mkdir /etc/vgpu_unlock

# 创建profile_override.toml文件

touch /etc/vgpu_unlock/profile_override.toml

# 创建nvidia-vgpud.service.d,nvidia-vgpu-mgr.service.d启动服务

mkdir /etc/systemd/system/{nvidia-vgpud.service.d,nvidia-vgpu-mgr.service.d}

# 写入路径信息

echo -e "[Service]\nEnvironment=LD_PRELOAD=/opt/vgpu_unlock-rs/target/release/libvgpu_unlock_rs.so" > /etc/systemd/system/nvidia-vgpud.service.d/vgpu_unlock.conf

echo -e "[Service]\nEnvironment=LD_PRELOAD=/opt/vgpu_unlock-rs/target/release/libvgpu_unlock_rs.so" > /etc/systemd/system/nvidia-vgpu-mgr.service.d/vgpu_unlock.conf

# 重新加载服务

systemctl daemon-reload执行完成后,cat下查看服务配置是否与下边一致cat /etc/systemd/system/{nvidia-vgpud.service.d,nvidia-vgpu-mgr.service.d}/*

[Service]

Environment=LD_PRELOAD=/opt/vgpu_unlock-rs/target/release/libvgpu_unlock_rs.so

[Service]

Environment=LD_PRELOAD=/opt/vgpu_unlock-rs/target/release/libvgpu_unlock_rs.so下载预编译好的libvgpu_unlock_rs.so文件

mkdir -p /opt/vgpu_unlock-rs/target/release

cd /opt/vgpu_unlock-rs/target/release

wget -O libvgpu_unlock_rs.so https://yangwenqing.com/files/pve/vgpu/vgpu_unlock/rust/libvgpu_unlock_rs_20230207_44d5bb3.so安装VGPU驱动

安装显卡驱动需要用到的依赖

apt install build-essential dkms mdevctl pve-headers-$(uname -r)# 下载显卡驱动

wget "https://yun.yangwenqing.com/NVIDIA/vGPU/NVIDIA/16.2/NVIDIA-Linux-x86_64-535.129.03-vgpu-kvm-patched.run"

# 赋予执行权限

chmod +x NVIDIA-Linux-x86_64-535.129.03-vgpu-kvm-patched.run

# 安装驱动(默认回车直至安装完成即可)

./NVIDIA-Linux-x86_64-535.129.03-vgpu-kvm-patched.run

# 重启

reboot其他补充提示:

1) 如之前安装过了显卡驱动,则需要先卸载,再安装

# 卸载显卡驱动

./NVIDIA-Linux-x86_64-535.129.03-vgpu-kvm-patched.run --uninstall

# 移除显卡相关程序

sudo apt-get remove --purge nvidia-*

# 安装驱动(默认回车直至安装完成即可)

./NVIDIA-Linux-x86_64-535.129.03-vgpu-kvm-patched.run2) 下载慢?试试aria2吧

# 在pve安装aria2

apt install aria2

# 4线程下载文件

aria2c -s 4 -x 4 -j 10 'https://yun.yangwenqing.com/NVIDIA/vGPU/NVIDIA/16.2/NVIDIA-Linux-x86_64-535.129.03-vgpu-kvm-patched.run'

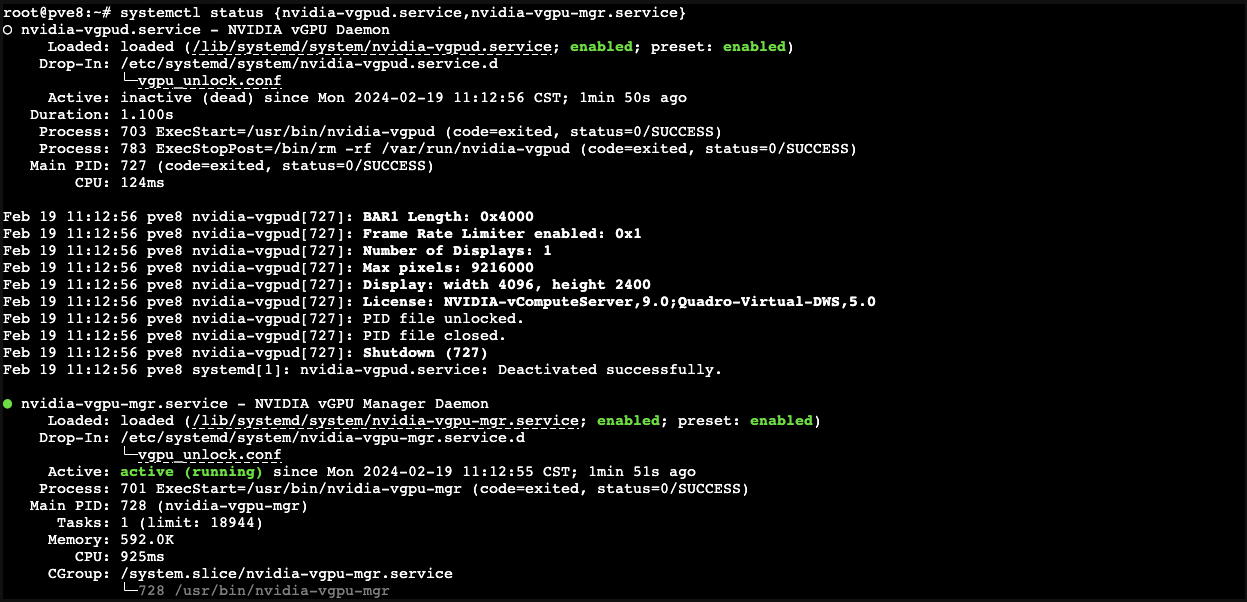

重启完成后查看相关服务状态

# 查看相关服务状态

systemctl status {nvidia-vgpud.service,nvidia-vgpu-mgr.service}

# 重新启动相关服务

systemctl restart {nvidia-vgpud.service,nvidia-vgpu-mgr.service}

# 停止相关服务

systemctl stop {nvidia-vgpud.service,nvidia-vgpu-mgr.service}

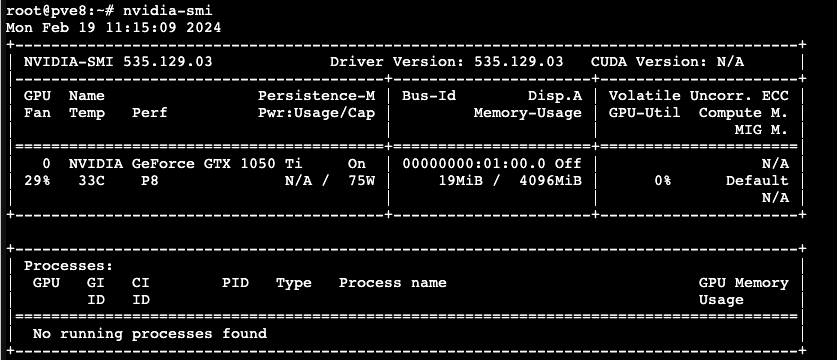

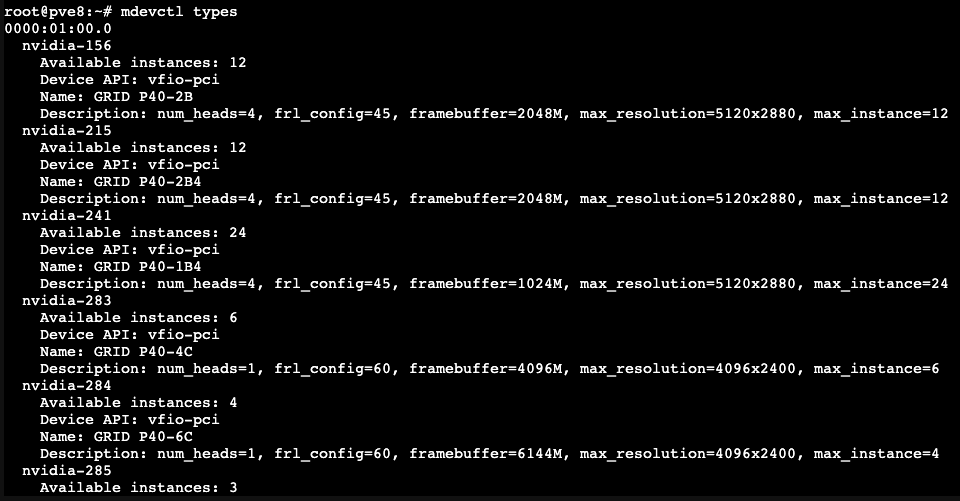

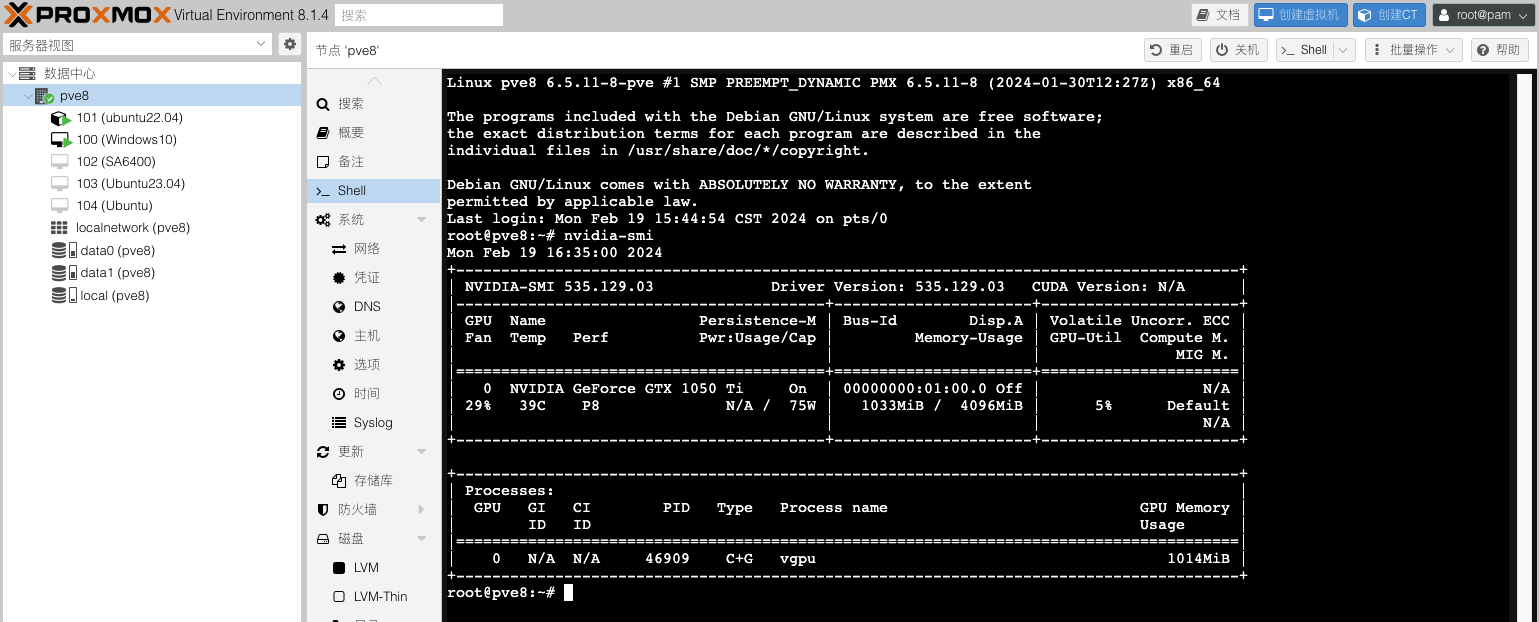

随后使用nvidia-smi

以及mdevctl types查看

搭建fastapi-dls授权服务

NVIDIA VGPU并非免费产品,需要对VGPU驱动购买许可才能正常使用VGPU,这里我用fastapi-dls项目来取得90天的试用许可。你可以在内网或者外网部署好Docker环境,然后搭建fastapi-dls授权服务,我这里提供一个pve lxc的Docker容器,部署到内网进行授权。

# 进入pve备份文件夹

cd /var/lib/vz/dump/

# 使用wget命令下载lxc docker 容器备份包

wget https://yun.yangwenqing.com/Proxmox/LXC/FASTAPI-DLS/vzdump-lxc-100-2023_11_14-15_docker.tar.zst

# 或者使用aria2c命令多线程下载lxc docker 容器备份包

aria2c -s 8 -x 8 -j 10 'https://yun.yangwenqing.com/Proxmox/LXC/FASTAPI-DLS/vzdump-lxc-100-2023_11_14-15_docker.tar.zst'LXC容器信息:

- 默认IP地址:192.168.2.99

- 账号:root

- 密码:123123

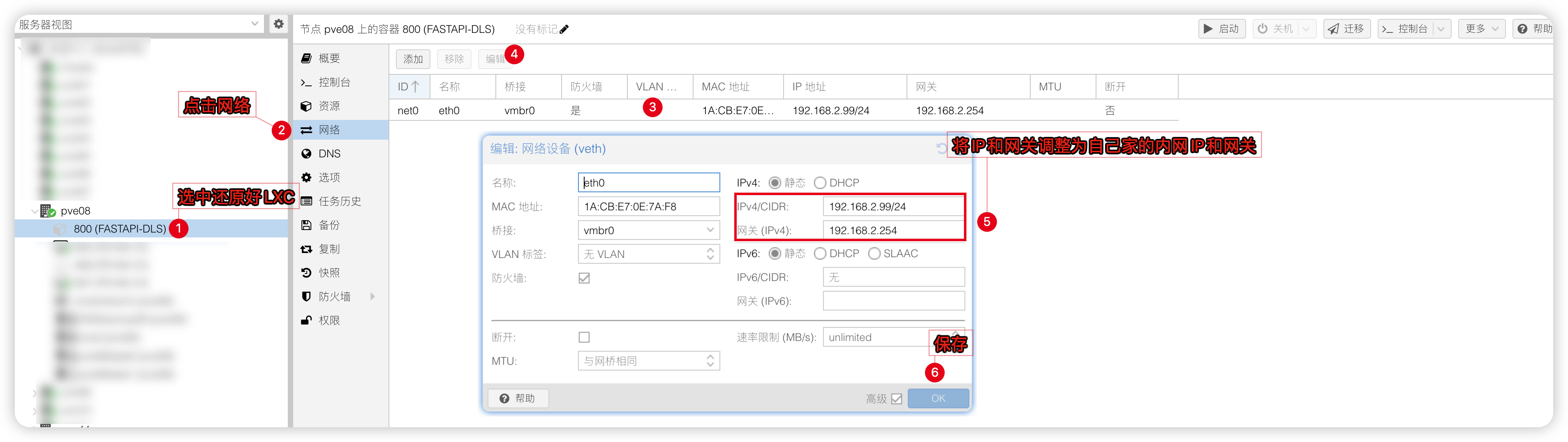

1)将下载下来的LXC容器进行还原

2)并将原来的IP改为自己内网的IP,我这里用的就是2网段就不改了。

3)登录LXC容器(账号:root密码:123123)并创建授权服务:

# 创建授权服务,注意下边的IP(192.168.2.99)改为刚刚自己修改好的

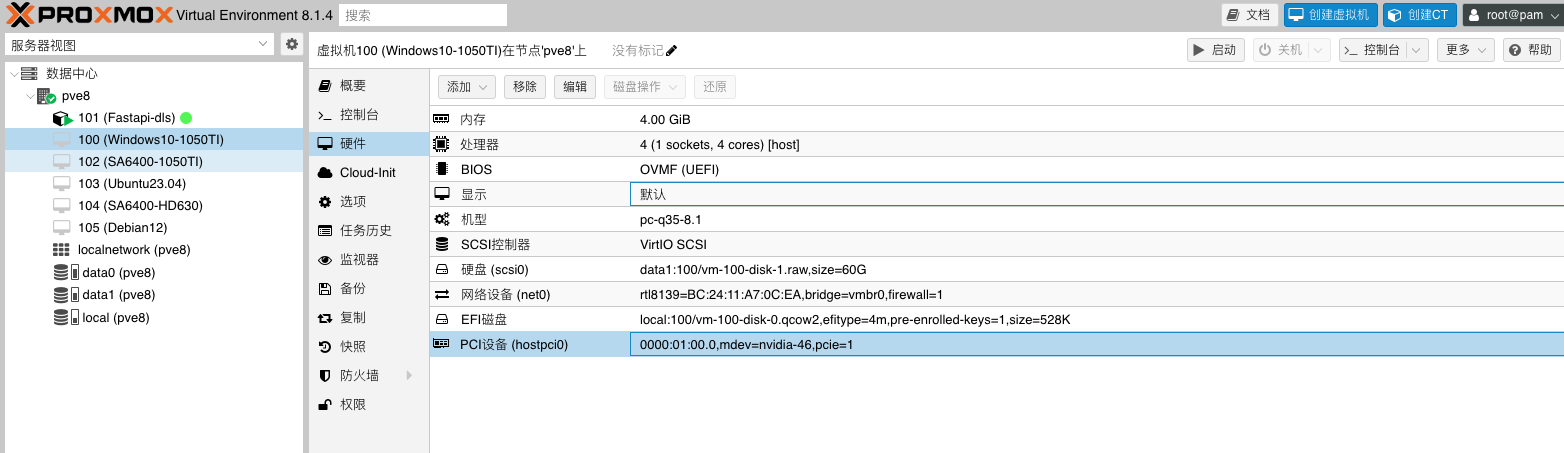

docker run --restart always -d -e DLS_URL=192.168.2.99 -e DLS_PORT=443 -p 443:443 makedie/fastapi-dls创建虚拟机(Win10为例)

创建win10虚拟机(21H2)

名称:自定义

光驱挂载:Win安装ISO镜像

系统中显卡:默认

机型:q35

BIOS:OVMF(

如果采用SeaBIOS引导,机型q35版本要选7.2及以下,否则无法正常授权驱动)EFI分区:UEFI(OVMF)需要

磁盘:SCSI 大小60G(按需设置,或硬盘直通)

CPU:host 核心数量4(按需设置)

内存:4G及以上

网络:virtIO(半虚拟化或网卡直通)网卡

建立好虚拟机后

添加CD/DVD设备1个,挂载virtIO驱动ISO镜像

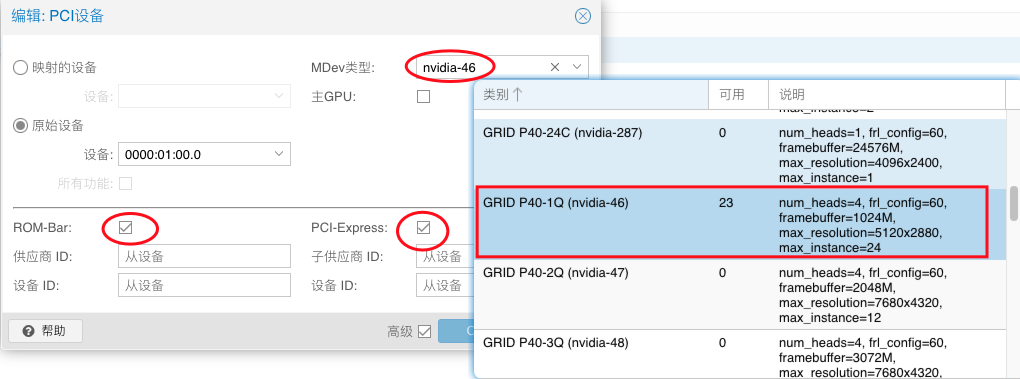

添加PCI设备:nvidia显卡(勾选ROM-Bar和PCIE在Mdev类型中选择vgpu设备)

其中 GRID P40-1Q 是 mdev 的名字,P40--显卡名,1--1G 显存,Q 代表 vWS

关于最后一位字母,如下

A = Virtual Applications (vApps)

B = Virtual Desktops (vPC)

C = AI/Machine Learning/Training (vCS or vWS)

Q = Virtual Workstations (vWS)(性能最佳)

在配置vgpu的时候,选择正确的型号型号即可。

资源下载

# 微软原版镜像 Windows 10 Enterprise LTSC 2021 (x64) - DVD (Chinese-Simplified).ISO

https://share.feijipan.com/s/CXF5hpGp

# virtIO驱动 virtio-win-0.1.240.iso

https://share.feijipan.com/s/MYF6dgDy

# NVIDIA Guest驱动 537.70

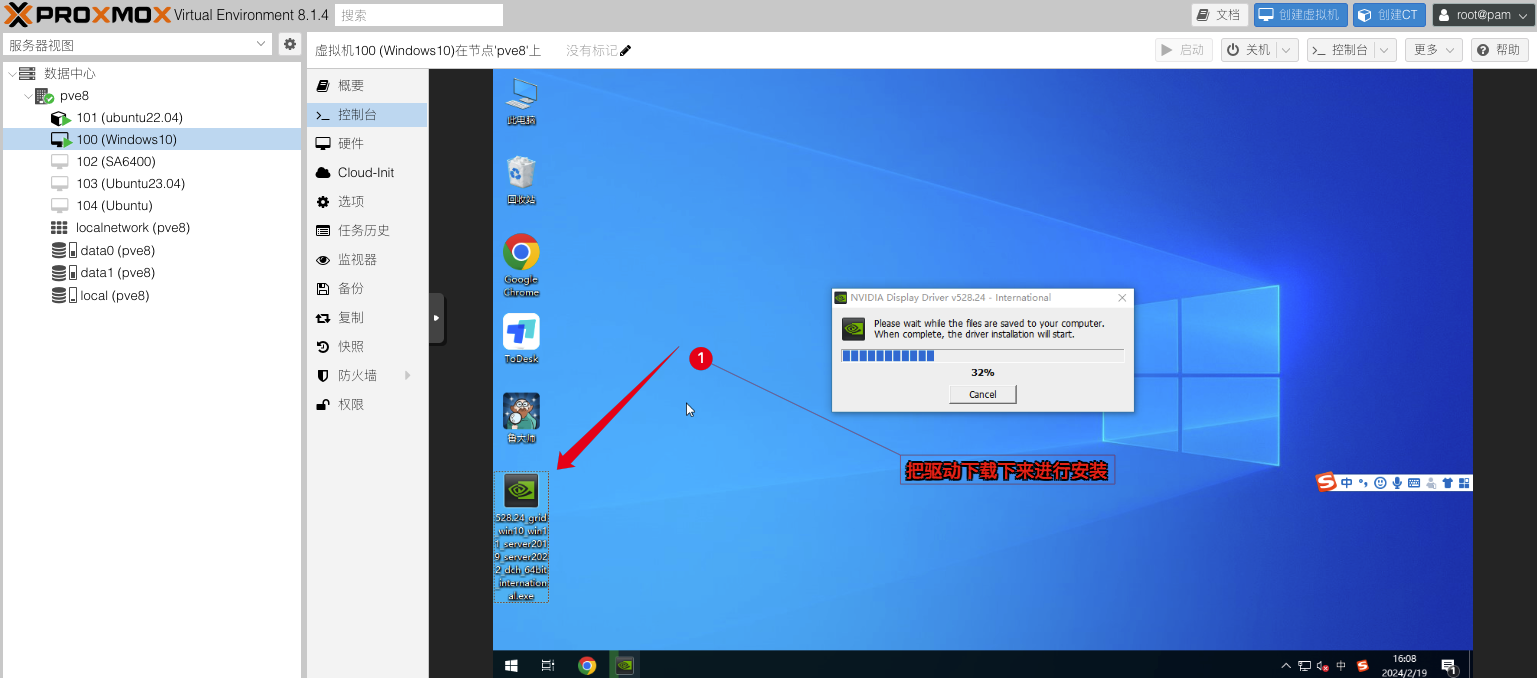

https://share.feijipan.com/s/WsF6dh3E安装NVIDIA Guest驱动

创建好系统之后,在系统中开启远程功能。如远程桌面,todesk,vnc,向日葵,parsec等然后安装 NVIDIA Guest驱动

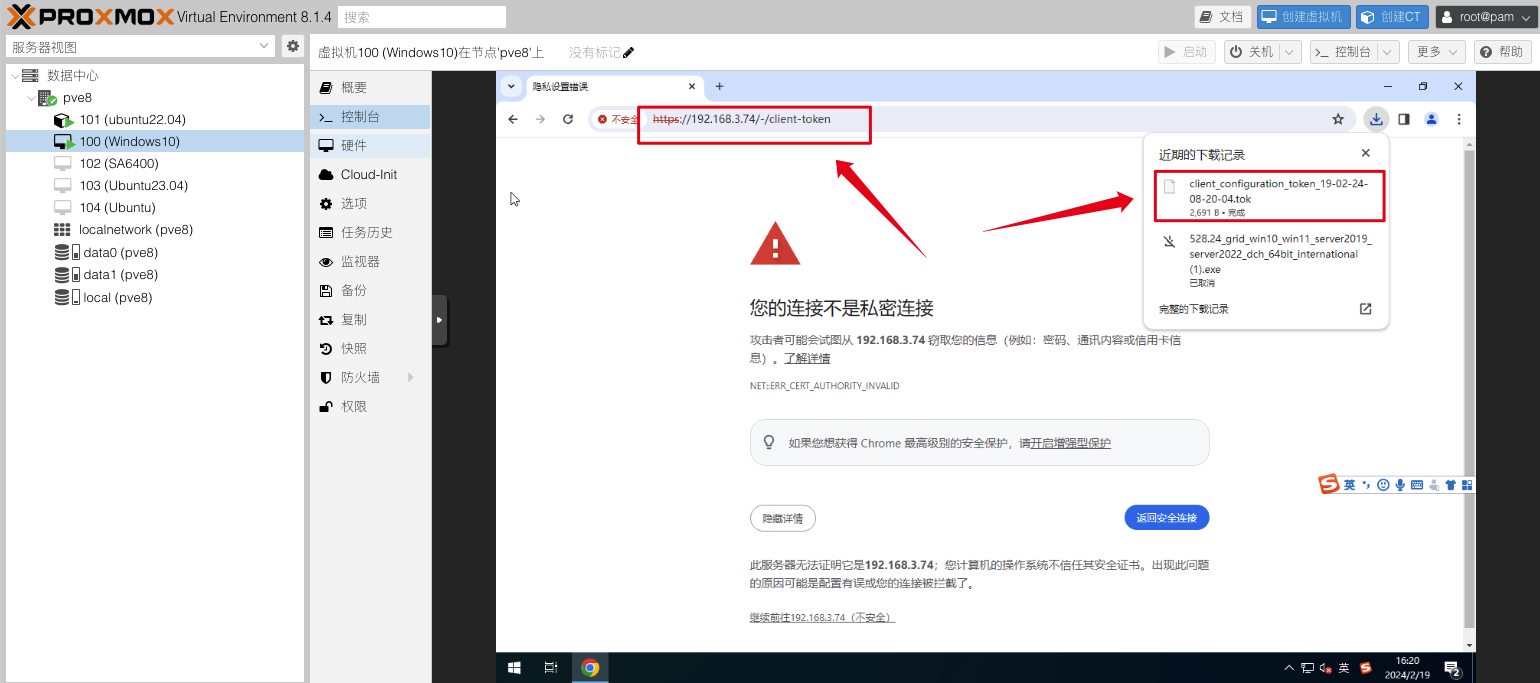

启用授权

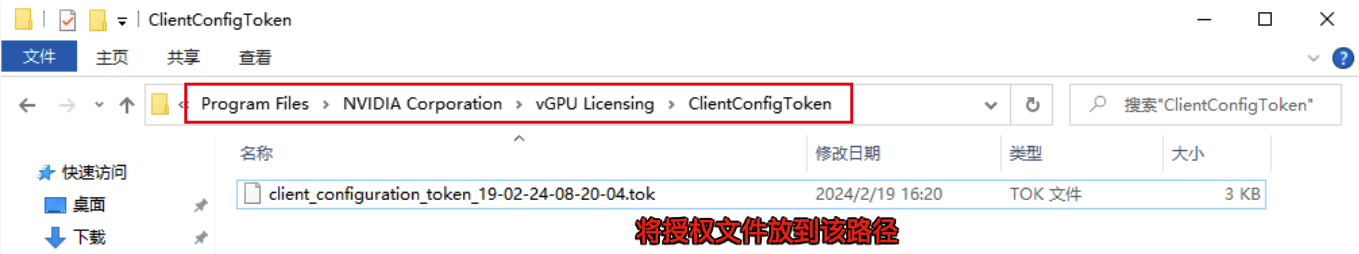

1)在浏览器访问fastapi-dls授权服务:https://192.168.2.99/-/client-token会自动下载好授权文件

2)下载后放入C:\Program Files\NVIDIA Corporation\vGPU Licensing\ClientConfigToken\这个目录下

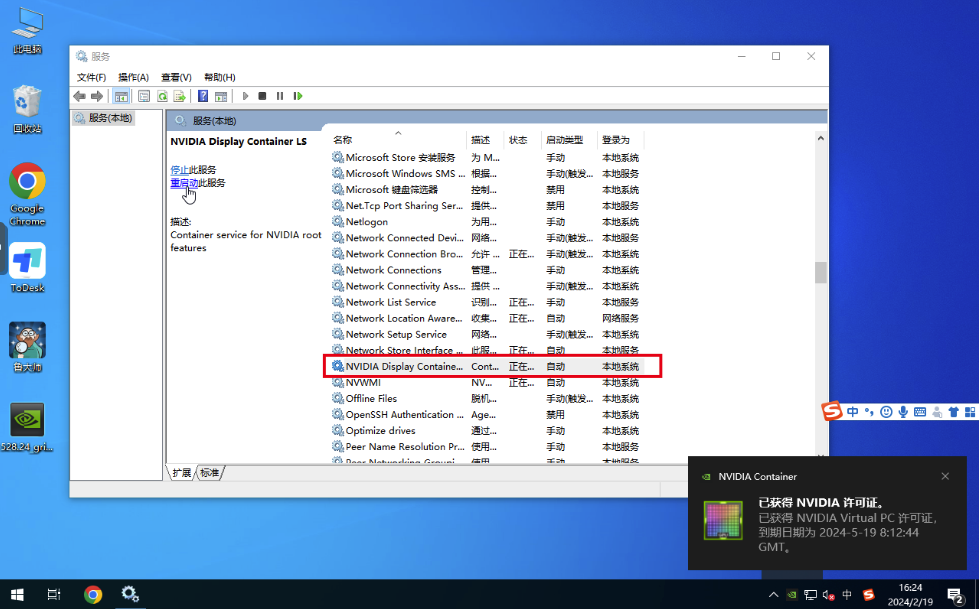

3) 重启NVIDIA Display Container Ls服务,即可获得授权

也可以在cmd窗口使用nvidia-smi -q命令查看授权情况如授权失败,需要检查电脑时间是否对得上授权服务器时间

4)使用Todesk远程工具连接上虚拟机跑个鲁大师测试一下,显卡是否正常工作

想解除60帧?

编辑

nano /etc/vgpu_unlock/profile_override.toml文件,加入以下信息关闭虚拟机重新开机生效。[profile.nvidia-46]

num_displays = 1

display_width = 1920

display_height = 1080

max_pixels = 2073600

cuda_enabled = 1

frl_enabled = 0

framebuffer = 939524096参数说明:

[profile.nvidia-46]nvidia-46 为vgpu型号的参数。如选的不是46则改成自己选的那个型号。

num_displays 最大显示器数量

display_width = 1920

display_height = 1080

max_pixels = 2073600 这3个是虚拟显示器的分辨率,max_pixels是长宽的乘积

cuda_enabled = 1是否开启cuda

frl_enabled = 0 是否限制帧数,0为不限制

framebuffer = 939524096 1GB显存,设定vgpu的显存

自定义显卡显存大小

如要自定义修改显卡的显存大小,只需要修改

framebuffer的值就好了,显存不建议低于1GB,官方说低于1GB将会禁用NVENC视频编解码器注意:vgpu会默认占用128M,所以如果要改显存,请将结果减去128M再去换算,旧版是减去64M例如,你期望显存为1GB,所以就用

1024M-64M=960M/1024M-128M=896M在线大小换算平台:https://www.bejson.com/convert/filesize/

5)在PVE后台查看是否调用成功

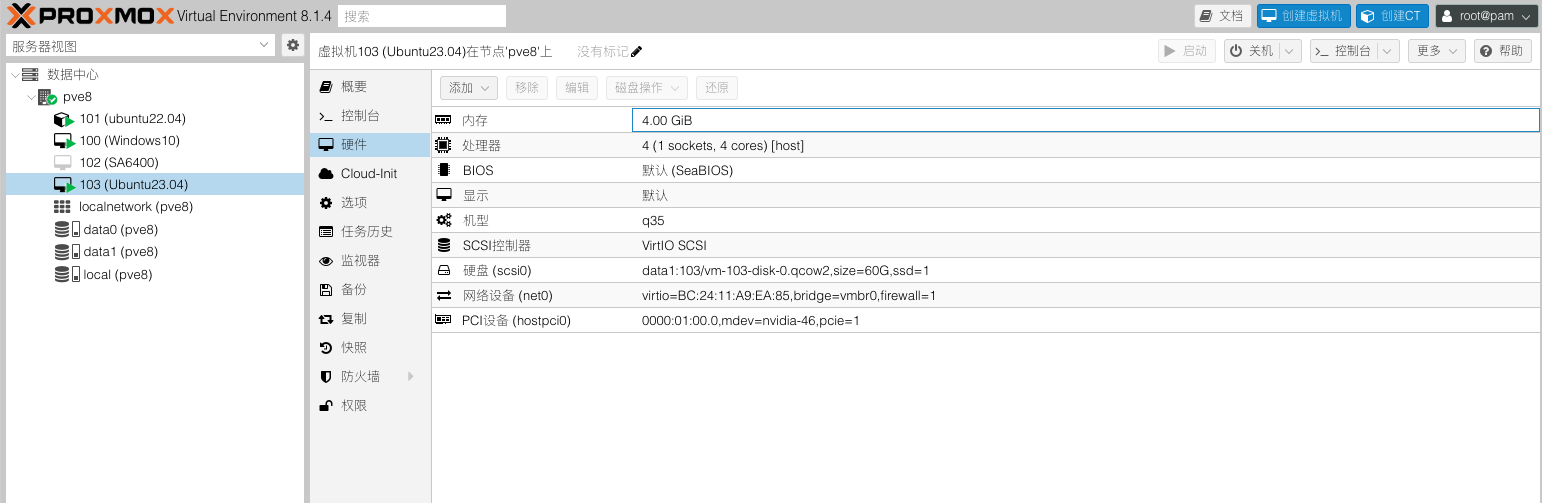

创建虚拟机(Ubuntu23.04为例)

创建Ubuntu虚拟机(2304)

名称:自定义

光驱挂载:Ubuntu安装ISO镜像

系统中显卡:默认

机型:q35

BIOS:默认 (SeaBIOS)

磁盘:SCSI 大小60G(按需设置,或硬盘直通)

CPU:host 核心数量4(按需设置)

内存:4G及以上

网络:virtIO(半虚拟化或网卡直通)网卡

添加PCI设备:nvidia显卡(勾选ROM-Bar和PCIE在Mdev类型中选择vgpu设备)

1) 安装显卡驱动前先将需要的依赖文件打上

# 安装ssh工具,使用第三方SSH工具(putty,终端)连接到Ubuntu,PVE里面控制台无法复制命令

sudo apt-get install openssh-server

# 开机自启ssh

sudo systemctl enable ssh.service

# 重启ssh服务

sudo systemctl restart ssh.service

# 需要所需依赖

sudo apt install build-essential linux-headers-generic libglvnd-dev pkg-config -y

# 安装dkms

sudo apt install dkms -y

# 安装32位兼容库

sudo dpkg --add-architecture i386

sudo apt update

sudo apt install libc6:i386 -y2)屏蔽自带的显卡驱动

# 创建blacklist-nouveau.conf文件

sudo nano /etc/modprobe.d/blacklist-nouveau.conf

# 在blacklist-nouveau.conf文件添加如下内容:

blacklist nouveau

options nouveau modeset=0

# 重载内核initramfs

sudo update-initramfs -u

# 重启Ubuntu

sudo reboot

# 重启完成后检查nouveau是否已禁用,没有任何输出说明已经禁用

lsmod | grep nouveau

# 切换到文本命令行控制台

sudo chvt 3

# 关闭图形界面服务

sudo service gdm stop3)安装显卡驱动

# 使用aria2c命令多线程下载 NVIDIA Guest驱动 535.129

aria2c -s 4 -x 4 -j 10 'https://yun.yangwenqing.com/NVIDIA/vGPU/NVIDIA/16.2/NVIDIA-GRID-Linux-KVM-535.129.03-537.70/Guest_Drivers/NVIDIA-Linux-x86_64-535.129.03-grid.run'

# 给可执行权限

chmod +x NVIDIA-Linux-x86_64-535.129.03-grid.run

# 安装驱动(默认回车直至安装完成即可)

./NVIDIA-Linux-x86_64-535.129.03-grid.run

# 安装完成重启Ubuntu

reboot4)重启完成后,使用nvidia-smi验证

root@Ubuntu23:~# nvidia-smi

Tue Feb 20 16:22:12 2024

+---------------------------------------------------------------------------------------+

| NVIDIA-SMI 535.129.03 Driver Version: 535.129.03 CUDA Version: 12.2 |

|-----------------------------------------+----------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+======================+======================|

| 0 GRID P40-1Q On | 00000000:01:00.0 Off | N/A |

| N/A N/A P8 N/A / N/A | 7MiB / 1024MiB | 0% Default |

| | | Disabled |

+-----------------------------------------+----------------------+----------------------+

+---------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=======================================================================================|

| 0 N/A N/A 801 G /usr/lib/xorg/Xorg 6MiB |

+---------------------------------------------------------------------------------------+启用授权

# 获取授权文件

wget --no-check-certificate -O /etc/nvidia/ClientConfigToken/client_configuration_token_$(date '+%d-%m-%Y-%H-%M-%S').tok https://192.168.2.99/-/client-token

# 或者

curl --insecure -L -X GET https://192.168.2.99/-/client-token -o /etc/nvidia/ClientConfigToken/client_configuration_token_$(date '+%d-%m-%Y-%H-%M-%S').tok验证授权

# 重启服务

sudo service nvidia-gridd restart

# 验证授权获取情况

nvidia-smi -q | grep License# 看到有Licensed字样,就授权好了。

root@Ubuntu23:~# nvidia-smi -q | grep License

vGPU Software Licensed Product

License Status : Licensed (Expiry: 2024-5-20 9:40:22 GMT)PVE去虚拟化检测部分

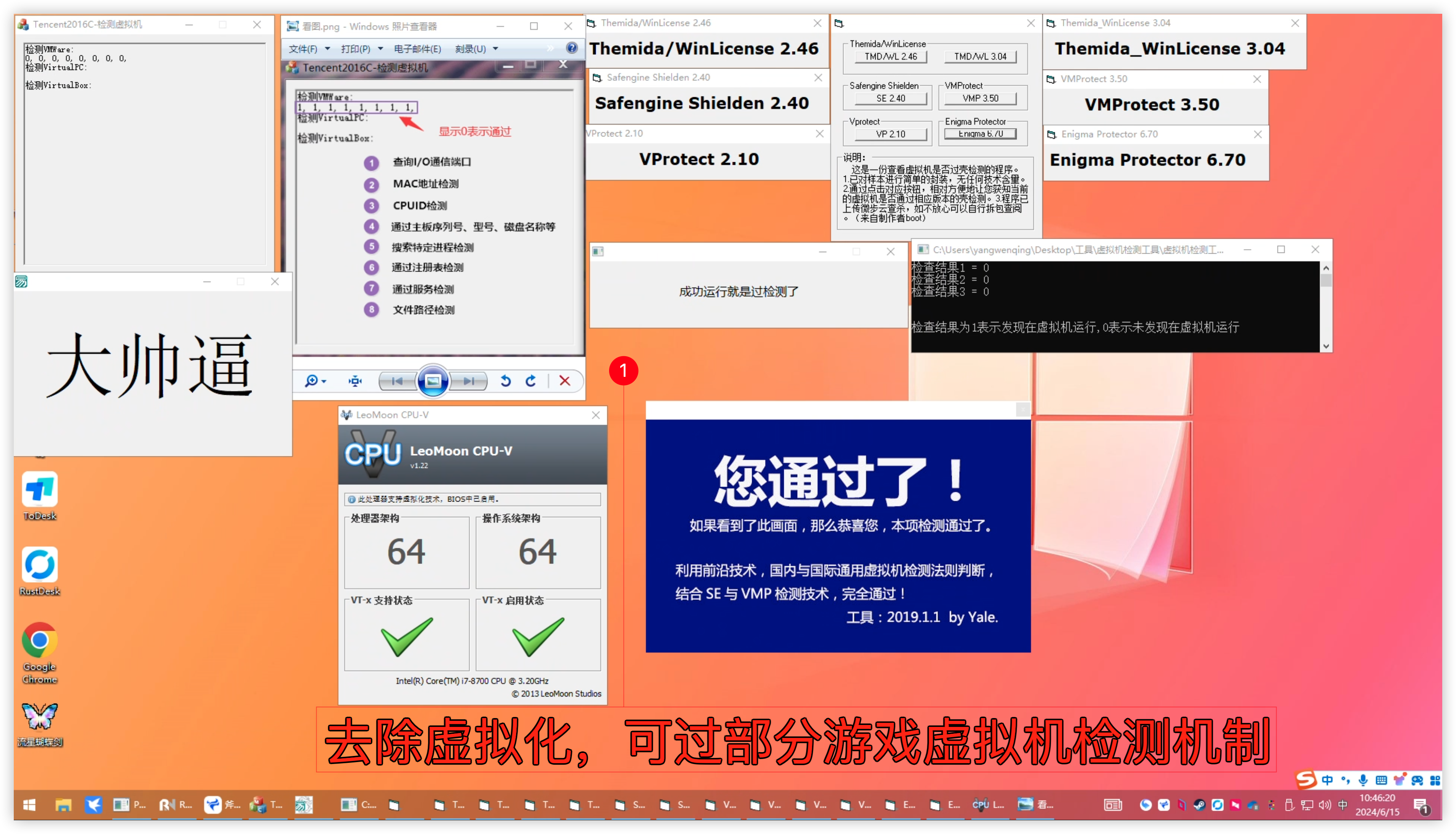

做完以上VGPU部分,就可以正常使用VGPU加速。专业设计,云桌面,Al深度学习用户可以不用往下看了。市面上大部分游戏都不支持在虚拟机进行游戏,如你有游戏需求,则还需要对虚拟机做以下去虚拟化操作。

# 查看你当前安装的pve-qemu-kvm版本

dpkg -l|grep kvm

# 我这里是8.1.5-3

ii pve-qemu-kvm 8.1.5-3 amd64 Full virtualization on x86 hardware安装去虚拟化修改后的版本

# 如果你的版本是9.0.2-2,执行一下命令下载并安装

wget https://yun.yangwenqing.com/Proxmox/Qemu%E5%8E%BB%E8%99%9A%E6%8B%9F%E5%8C%96/9.0.2-2/pve-qemu-kvm_9.0.2-2_amd64_anti_detection20240818v1.0.deb

dpkg -i pve-qemu-kvm_9.0.2-2_amd64_anti_detection20240818v1.0.deb

# 如果你的版本是8.1.5-3,执行一下命令下载并安装

wget wget https://yun.yangwenqing.com/Proxmox/Qemu%E5%8E%BB%E8%99%9A%E6%8B%9F%E5%8C%96/8.1.5-3/pve-qemu-kvm_8.1.5-3_amd64.deb

dpkg -i pve-qemu-kvm_8.1.5-3_amd64.deb

Intel核显直通,在虚拟机配置文件加入以下参数nano /etc/pve/qemu-server/虚拟机ID.conf

args: -set device.hostpci0.addr=02.0 -set device.hostpci0.x-igd-gms=0x2 -set device.hostpci0.x-igd-opregion=on -cpu host,hypervisor=off,vmware-cpuid-freq=false,enforce=false,host-phys-bits=true -smbios type=0,vendor="American Megatrends International LLC.",version=H3.7G,date='02/21/2023',release=3.7 -smbios type=1,manufacturer="Maxsun",product="MS-Terminator B760M",version="VER:H3.7G(2022/11/29)",serial="Default string",sku="Default string",family="Default string" -smbios type=2,manufacturer="Maxsun",product="MS-Terminator B760M",version="VER:H3.7G(2022/11/29)",serial="Default string",asset="Default string",location="Default string" -smbios type=3,manufacturer="Default string",version="Default string",serial="Default string",asset="Default string",sku="Default string" -smbios type=17,loc_pfx="Controller0-ChannelA-DIMM",manufacturer="KINGSTON",speed=3200,serial=DF1EC466,part="SED3200U1888S",bank="BANK 0",asset="9876543210" -smbios type=4,sock_pfx="LGA1700",manufacturer="Intel(R) Corporation",version="12th Gen Intel(R) Core(TM) i7-12700",max-speed=4900,current-speed=3800,serial="To Be Filled By O.E.M.",asset="To Be Filled By O.E.M.",part="To Be Filled By O.E.M." -smbios type=8,internal_reference="CPU FAN",external_reference="Not Specified",connector_type=0xFF,port_type=0xFF -smbios type=8,internal_reference="J3C1 - GMCH FAN",external_reference="Not Specified",connector_type=0xFF,port_type=0xFF -smbios type=8,internal_reference="J2F1 - LAI FAN",external_reference="Not Specified",connector_type=0xFF,port_type=0xFF -smbios type=11,value="Default string"AMD核显直通,Intel、AMD、NVIDIA三家独显直通,在虚拟机配置文件加入以下参数nano /etc/pve/qemu-server/虚拟机ID.conf

args: -cpu host,hypervisor=off,vmware-cpuid-freq=false,enforce=false,host-phys-bits=true -smbios type=0,vendor="American Megatrends International LLC.",version=H3.7G,date='02/21/2023',release=3.7 -smbios type=1,manufacturer="Maxsun",product="MS-Terminator B760M",version="VER:H3.7G(2022/11/29)",serial="Default string",sku="Default string",family="Default string" -smbios type=2,manufacturer="Maxsun",product="MS-Terminator B760M",version="VER:H3.7G(2022/11/29)",serial="Default string",asset="Default string",location="Default string" -smbios type=3,manufacturer="Default string",version="Default string",serial="Default string",asset="Default string",sku="Default string" -smbios type=17,loc_pfx="Controller0-ChannelA-DIMM",manufacturer="KINGSTON",speed=3200,serial=DF1EC466,part="SED3200U1888S",bank="BANK 0",asset="9876543210" -smbios type=4,sock_pfx="LGA1700",manufacturer="Intel(R) Corporation",version="12th Gen Intel(R) Core(TM) i7-12700",max-speed=4900,current-speed=3800,serial="To Be Filled By O.E.M.",asset="To Be Filled By O.E.M.",part="To Be Filled By O.E.M." -smbios type=8,internal_reference="CPU FAN",external_reference="Not Specified",connector_type=0xFF,port_type=0xFF -smbios type=8,internal_reference="J3C1 - GMCH FAN",external_reference="Not Specified",connector_type=0xFF,port_type=0xFF -smbios type=8,internal_reference="J2F1 - LAI FAN",external_reference="Not Specified",connector_type=0xFF,port_type=0xFF -smbios type=11,value="Default string" 如要还原回原来的官方包pve-qemu-kvm可以到清华源去下载安装

# pve8到这个链接下载

https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian/dists/bookworm/pve-no-subscription/binary-amd64/

# pve7到这个链接下载

https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian/dists/bullseye/pve-no-subscription/binary-amd64/

# 下载名为pve-qemu-kvm_x.x.x-x_amd64.deb就是了。

pve-qemu-kvm_8.1.5-3_amd64.deb 27.0 MiB 2024-02-22 03:18

pve-qemu-kvm_8.1.5-4_amd64.deb 27.0 MiB 2024-03-12 22:52

pve-qemu-kvm_8.1.5-5_amd64.deb 27.0 MiB 2024-04-12 02:40

pve-qemu-kvm_8.1.5-6_amd64.deb 27.0 MiB 2024-04-29 22:50

pve-qemu-kvm_8.2.2-1_amd64.deb 28.1 MiB 2024-04-29 16:50去除虚拟化后,大部分游戏其实已经可以正常玩了。[高级]点的游戏对虚拟机检测机制不好过,类似腾讯游戏有ACE这类检测机制就玩不了。

相关文章参考

GitLab-NVIDIA VGPU 指南

佛西博客-在Proxmox VE 7.4 中开启NVIDIA P106显卡虚拟化(vGPU)

B站李晓流-pve反虚拟化检测玩游戏

14 条评论

云盘不可用了,能恢复下吗

已恢复

非常感谢你的教程,我这边 全部搞好了,被FastAPI-DLS 授权难住了,明明授权文件已经 放到目录里面了 一直授权不成功,时间也同步了,希望您帮看看 问题出在哪里了

root@FASTAPI-DLS:~# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

b5c21162365b makedie/fastapi-dls "uvicorn main:app --…" 7 hours ago Up 4 minutes (healthy) 0.0.0.0:443->443/tcp, :::443->443/tcp upbeat_wiles

7daba5d222b0 6053537/portainer-ce "/portainer" 12 months ago Up 4 minutes 8000/tcp, 9443/tcp, 0.0.0.0:9000->9000/tcp, :::9000->9000/tcp portainer

root@FASTAPI-DLS:~#

我看到授权 服务里 upbeat_wiles 和你图片 里面 不一样,我不知道问题在哪,希望你能给点提示,万分感激

已经 搞定了 非常 感谢 站长

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: notice: vmiop_log: (0x0): FRL Value: 60 FPS

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: notice: vmiop_log: ######## vGPU Manager Information: ####>

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: notice: vmiop_log: Driver Version: 535.129.03

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: cmd: 0x2080012f failed.

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: error: vmiop_log: (0x0): Attempt to set framebufferlength >

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: error: vmiop_log: (0x0): init_device_instance failed for i>

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: error: vmiop_log: (0x0): Initialization: init_device_insta>

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: error: vmiop_log: display_init failed for inst: 0

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: error: vmiop_env_log: (0x0): vmiope_process_configuration:>

Nov 28 16:31:12 tc01 nvidia-vgpu-mgr[59049]: error: vmiop_env_log: (0x0): vmiope_process_configuration >

启动后关机就无法在开启了

请问您有出现过重启后虚拟机驱动丢失 每次都需要重新打的情况吗

rtx3050 8g的能不能做vgpu

不错不错,我喜欢看

请问下,你有遇到遇到pve 宿主机内存异常增长的情况吗

虚拟机需要安装qemu-guest-agent

Package 'build-essential' has no installation candidate

提示这个怎么解决

内核不支持

start failed:QEMU exit

错误。打不开

虚拟机配置有问题